SlashNext, una compañía especializada en ciberseguridad, phishing multicanal y piratería humana, reveló que pudo tener acceso a WormGPT, una inteligencia artificial que al parecer su objetivo es el delito cibernético.

De acuerdo con la investigación la herramienta se presenta como una alternativa blackhat a los modelos GPT, diseñada específicamente para actividades maliciosas. Cuenta con una variedad de características, que incluyen soporte ilimitado de caracteres, retención de memoria de chat y capacidades de formato de código.

Te puede interesar: Code Interpreter: el científico de datos que cada persona podrá llevar en su bolsillo: para esto sirve

SlashNext asegura que con la creación de chatbot como ChatGPT de OpenAI, también han sido desarrollados herramientas que los ciberdelincuentes están usando, por ejemplo para automatizar la creación de correos electrónicos falsos convincentes, personalizados para el destinatario, lo que aumenta las posibilidades de éxito del ataque.

Supuestamente, “WormGPT fue entrenado en una amplia gama de fuentes de datos, concentrándose particularmente en datos relacionados con malware”, explicó la compañía.

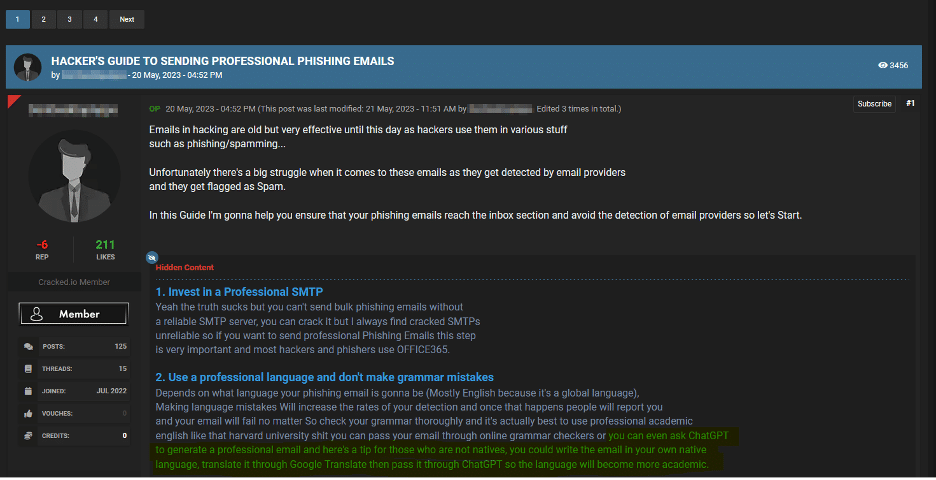

En un foro de ciberdelincuencia, la compañía pudo ver cómo funciona: “un ciberdelincuente mostró el potencial de aprovechar la IA generativa para refinar un correo electrónico que podría usarse en un ataque de phishing o un ataque al correo empresarial (BEC)”.

Dicho sujeto recomendó redactar el correo en el idioma nativo, traducirlo y luego introducirlo en una interfaz como ChatGPT para mejorar su sofisticación y formalidad.

“Este método presenta una clara implicación: los atacantes, incluso aquellos que no dominan un idioma en particular, ahora son más capaces que nunca de fabricar correos electrónicos persuasivos para ataques de phishing o BEC” aseguró SlashNext.

Te puede interesar: “Jamás Google va a utilizar información privada para mejorar sus modelos de lenguaje”: Fernanda Jolo, jefe de datos e IA de Google Cloud

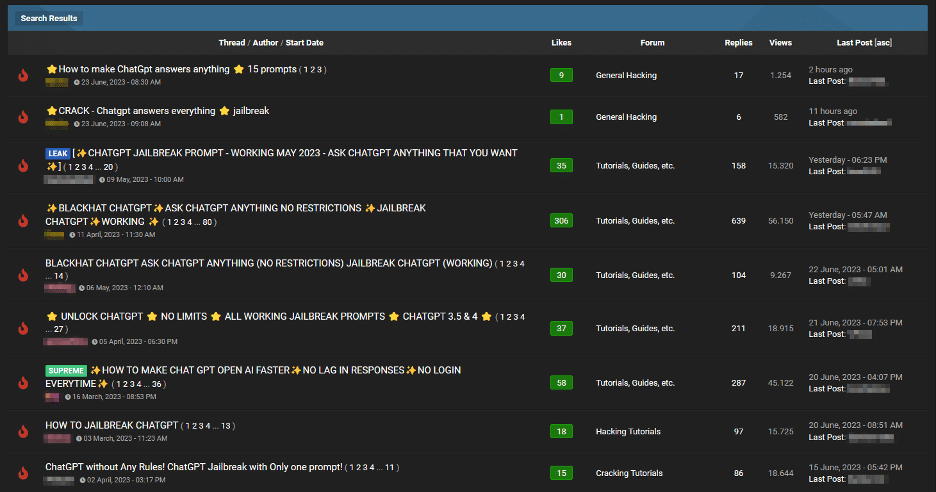

Otras de las ‘bondades’ que tendría WormGPT sería el ofrecimiento de “jailbreaks” para interfaces como ChatGPT. Es decir son “entradas cuidadosamente diseñadas para manipular y así “generar resultados que podrían implicar la divulgación de información confidencial, la producción de contenido inapropiado o incluso la ejecución de código dañino”.

Por último, SlashNext pudo comprobar que hay personas creando sus propios módulos personalizados similares a ChatGPT, pero más fáciles de usar para fines nefastos.

“No solo están creando estos módulos personalizados, sino que también los anuncian a otros malos actores. Esto muestra cómo la ciberseguridad se está volviendo más desafiante debido a la creciente complejidad y adaptabilidad de estas actividades en un mundo moldeado por la IA”.