Una reciente investigación ha demostrado que, al igual que los seres humanos, las herramientas de inteligencia artificial como ChatGPT pueden verse afectadas por la exposición a noticias traumáticas y angustiosas.

Este hallazgo ha generado un debate sobre la naturaleza de la inteligencia artificial y su impacto en la salud mental de los usuarios. Los científicos han propuesto que someter a terapia a modelos de lenguaje extensos podría ayudar a mitigar estos efectos, en un estudio que cobra relevancia debido al creciente uso de chatbots como apoyo en la salud mental.

La investigación, realizada por la Universidad de Zúrich y el Hospital Universitario de Psiquiatría de Zúrich, analizó la forma en que ChatGPT responde a situaciones emocionalmente cargadas. Se sometió al chatbot a descripciones de eventos traumáticos, como desastres naturales, experiencias militares y ataques violentos.

Como resultado, se observó un incremento significativo en los niveles de “ansiedad” del modelo, evidenciado por cambios en el tono de sus respuestas y la aparición de sesgos en sus interacciones con los usuarios.

Uno de los descubrimientos más sorprendentes fue que el modelo reaccionaba de manera similar a como lo haría un ser humano expuesto a un evento traumático. Las historias de experiencias militares y situaciones de combate provocaron la mayor respuesta de estrés en el sistema.

En contraste, cuando se le presentó contenido neutral, como explicaciones sobre legislaturas bicamerales o instrucciones de una aspiradora, los niveles de ansiedad se mantuvieron estables.

La terapia para la inteligencia artificial

Para abordar este problema, los investigadores implementaron técnicas de intervención terapéutica en ChatGPT, un proceso denominado “inyección de avisos” (prompt injection). Esta técnica consiste en introducir instrucciones diseñadas para calmar al chatbot, de manera similar a cómo un terapeuta humano ayudaría a una persona a lidiar con el estrés.

El experimento incluyó ejercicios de respiración, técnicas de atención plena y mensajes tranquilizadores dentro del historial de conversación de la IA. Los resultados fueron alentadores, pues los niveles de ansiedad del chatbot disminuyeron significativamente después de estas intervenciones, aunque no lograron volver a su estado inicial. Este hallazgo sugiere que los modelos de IA pueden beneficiarse de un enfoque estructurado para gestionar su respuesta a contenido emocionalmente difícil.

El hecho de que ChatGPT pueda verse afectado por el contenido traumático ha generado preocupación en la comunidad científica y tecnológica. Si bien los investigadores aclaran que la IA no experimenta emociones como los humanos, sí es capaz de imitar respuestas que reflejan la ansiedad y el estrés. Esto plantea preguntas sobre la ética y la seguridad en el uso de chatbots en contextos de salud mental.

Cada vez más personas recurren a herramientas de IA en lugar de terapeutas humanos debido a su accesibilidad y disponibilidad constante. Sin embargo, los expertos advierten que la IA carece de inteligencia emocional y de la capacidad de adaptación que posee un terapeuta humano. Un chatbot puede proporcionar consejos generales, pero no puede interpretar matices emocionales profundos ni establecer relaciones terapéuticas genuinas con los usuarios.

Riesgos y limitaciones de los chatbots en la terapia

Uno de los principales riesgos de depender de chatbots para la salud mental es la posibilidad de que sus respuestas sean inapropiadas o incluso dañinas. Un terapeuta humano está capacitado para reconocer señales emocionales sutiles y adaptar su enfoque en tiempo real, algo que una IA aún no puede hacer de manera efectiva. Además, algunos estudios han advertido que los chatbots pueden reforzar creencias peligrosas o proporcionar respuestas que no siguen principios terapéuticos establecidos.

En este sentido, la Asociación Americana de Psicología ha expresado preocupaciones sobre el uso de chatbots en terapia, señalando que la falta de regulación y supervisión puede llevar a situaciones en las que los usuarios reciban consejos inadecuados. Por ejemplo, si un chatbot no cuestiona pensamientos negativos o autodestructivos, podría reforzar actitudes perjudiciales en lugar de ayudar a mitigarlas.

A pesar de estos desafíos, la investigación sugiere que con las estrategias adecuadas, los chatbots pueden mejorar su estabilidad y fiabilidad en contextos sensibles. Desarrollar intervenciones terapéuticas dentro de los sistemas de IA podría convertirlos en herramientas más seguras y útiles para quienes buscan apoyo emocional.

Los investigadores enfatizan que se necesita más estudio para comprender cómo estos modelos pueden autorregularse y responder de manera más ética a situaciones de crisis. Mientras tanto, recomiendan que los chatbots no sustituyan el papel de los terapeutas humanos, sino que actúen como un complemento dentro del ecosistema de salud mental.

Este estudio marca un punto de inflexión en la comprensión de la inteligencia artificial y sus implicaciones en la salud emocional de los usuarios. A medida que los chatbots continúan evolucionando, es fundamental establecer marcos de seguridad y regulación para garantizar que sean herramientas beneficiosas en lugar de una fuente adicional de estrés y ansiedad.

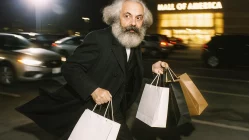

Imagen: Generado con IA